Trägt man Kopfhörer mit Spatial Audio, dann hört man entsprechend abgemischte Musik räumlich, d.h. man verortet Instrumente im Raum und nicht nur links und rechts. Dieses Erlebnis lässt sich mit iOS 16, das ab Montag zur Installation allgemein verfügbar ist, an die eigene Physis anpassen. Unser räumliches Hörvermögen ist so stark geprägt, dass es nicht mehr korrekt funktioniert, wenn man nur die Ohrmuscheln zukleistert. Für die Personalisierung braucht man ein iPhone mit FaceID, weil die 3D-Kamera benutzt wird, die Form des Kopfes und die beider Ohrmuscheln zu vermessen.

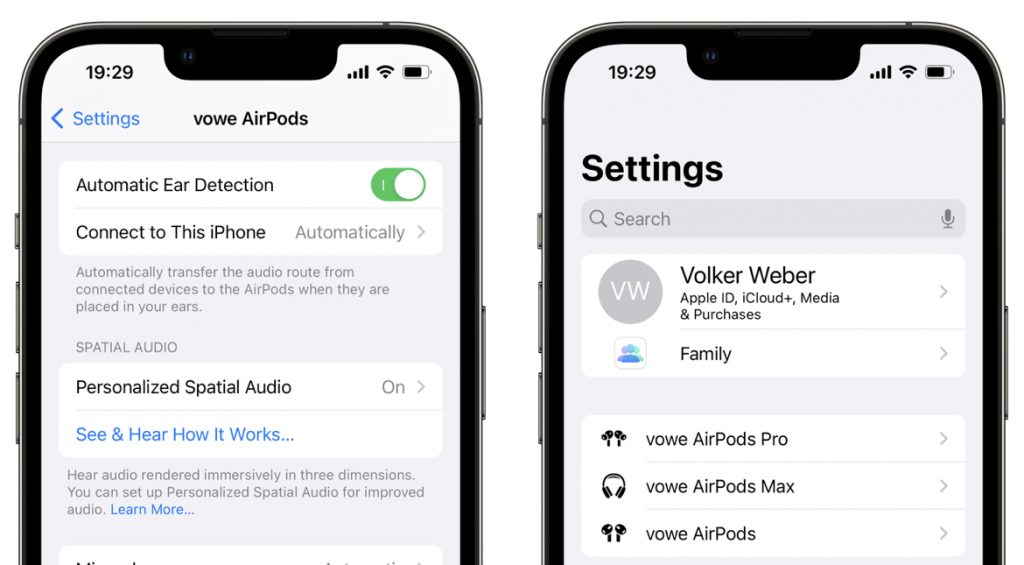

In der Apple Keynote klang es so, also ob Personalisiertes Spatial Audio in iOS 16 nur mit den neuen AirPods Pro 2 funktioniert, aber tatsächlich wird es auch mit AirPods 3, AirPods Pro und AirPods Max unterstützt.Mir ist das aufgefallen, weil ich den Release Candidate von iOS auf meinem iPhone installiert hatte. Man wird zur Vermessung aufgefordert, wenn man erstmals die AirPods wieder aufsetzt. Dann habe ich alle drei durchprobiert und festgestellt, dass es sofort mit allen Modellen funktioniert.

Das Vermessen der Ohrmuschel ist der entscheidende Punkt. Der Abstand der Ohren ist nicht so entscheidend. Nur mit einem Korrekturfile gelingt das räumliche Hören tatsächlich. Ohne kann nicht jeder Spatial Audio genießen, manche hören ohne Korrektur gar nicht räumlich.

Ich habe diese Woche einen Dolby Atmos Mix auf einem Kopfhörer ohne Korrektur erstellt. Vorne/hinten oder oben/unten ist da schon schwierig zu verorten. Erstellt wird der Mix in 7.1.4 und dann binaural für den Kopfhörer gerendert.

Ich habe mich hier vor einiger Zeit zu Immersive Audio geäußert. Damals noch Wildwuchs, sind wir heute schon brauchbar standardisiert. Alle benutzen den Dolby Atmos Renderer, der alle Auflösungen (2.0, 5.1, 7.1.4, binaural etc.) gleichzeitig rendert. Das Mixen von Musik ist schon ein ganz anderer Vorgang wie in Stereo. Da gibt es Beds und bis zu 128 Objects, die im Raum platziert werden wollen. Das muss man erst mal abstrahieren und umsetzten.

Kinders, das ist schon ziemlich cool und wird dauerhaft bleiben. Apple gleicht sich mit jedem Release mehr an Dolby an und alle (Netflix, Spotify, Amazon, YouTube etc.) investieren Unsummen in das neue Format.

Spotify, YouTube und auch Sony Music haben inzwischen reichlich Atmos auf Lager, einfach mal suchen.

Auch im Live-Bereich halten diese Systeme Einzug, unter https://www.dbsoundscape.com mal die Stories anschauen. Sogar In Ear Monitoring für Künstler gibt es schon immersive: https://www.klang.com/de/products/klang_konductor

Das Feature funktioniert auch an den anderen Geräten, weil die Daten über iCloud synchronisiert werden. Ich finde es sehr schade, dass das gleiche noch nicht mit den Audiogrammen gemacht wird. Die hängen an Health das es nur auf dem iPhone gibt. Möchte ich auch mal an einem anderen Gerät (viel) besser hören, muss ich das über das iPhone per Airplay spiegeln 🙁